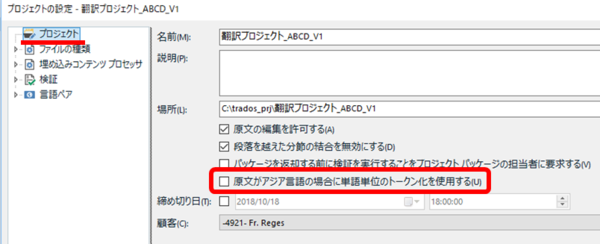

�O��̋L���Ŏ������Ȃ荬�����Ă����u�P��P�ʂ̃g�[�N�����v�ł����A�R�~���j�e�B�Ŏ��₳���Ă��������ASDL �̃u���O��ǂݒ������肵�āA�Ȃ�ƂȂ������ł��܂����B�Q�l�ɂ��� SDL �̋L���́A�u�|�����̌݊��� SDL Trados Studio 2019 / 2017 / 2015�v�ƁuTrados Studio 2019 – �i���������{�ꌴ���̉���v�ł��B

���_�Ƃ��ẮA���݂܂���AupLIFT ���ǂ��Ƃ��A�}�b�`�����ǂ��������̂́A�قڎ��̊��Ⴂ�ł����B�ȒP�ɂ܂Ƃ߂�ƁA����Ȋ����ł��B

�E�P��P�ʂ̃g�[�N�����͒P�ꐔ�𐔂��邽�߂̋@�\

�E���i���̋@�\���g�����Ƃ͂Ȃ��̂ŁA�f�t�H���g�̂܂ܖ����ɂ��Ă����悢

�u�P��P�ʂ̃g�[�N�����v�́A���{��̌����ɂ��āA�������ł͂Ȃ��A�P�ꐔ��m�肽���Ƃ��ɂ̂ݎg���@�\�������ł��B�u�P�ꐔ�v�������Ӗ�����̂��͌�q���܂����A���������{��̂Ƃ��ɒP�ꐔ���K�v�ɂȂ邱�Ƃ͂قڂȂ��̂ŁA���͂��̋@�\���g�p����@����قڂ���܂���B���͂��낢��Ƌ^���čl���Ă��܂��āA���̋@�\�� upLIFT �̓���ɉe������̂ł͂Ȃ����A�}�b�`���̌v�Z���|��҂ɂƂ��ĕs���ɂȂ�̂ł͂Ȃ����A�ȂǂƐS�z���Ă��܂����������������Ƃ͂Ȃ������ł��B

���{��̒P�ꐔ

�P��P�ʂ̃g�[�N�����ƒP�ꐔ�ɂ��ẮA��L�ɋ������u���O�́uTrados Studio 2019 – �i���������{�ꌴ���̉���v�ɐ�������Ă��܂��B�ŏ����炱�̋L����f���ȋC�����œǂ�ł���A����Ȃɍ������邱�Ƃ͂Ȃ������Ǝv���܂��B���A���݂܂���A�������N�̏K���ŁATrados ����̏��ɂ͉����ʂ̈Ӗ������肻���Ƃ��A�����ǂ���̈Ӗ��̂͂����Ȃ��Ƃ��A����ȋC�����Ŏ��͂��̋L����ǂ�ł��܂��܂����B

��Ƃ��āA�uWAF�̖����v�Ƃ������{��̒P�ꐔ���l���Ă݂܂��B���̓��{��̃J�E���g�́A�ȉ��̂悤�ɂȂ�܂��B

�@�@�@ �P��P�ʂ̃g�[�N�������g�p���Ȃ��ꍇ --> 4 �P��

�@�@�A �P��P�ʂ̃g�[�N�������g�p����ꍇ --> 3 �P��

�@ �̏ꍇ�A�uWAF�v�Ƃ����p�����̂����܂�� 1 �P��Ɛ����A����ȊO�͕��������̂܂ܐ����܂��BWord �́u�P�ꐔ�v�Ɠ����J�E���g���@�ł��B����ɑ��A�P��P�ʂ̃g�[�N�������g�p���� �A �̏ꍇ�́A�uWAF�v�A�u���v�A�u�����v�� 3 �P��ƂȂ�܂��B

���{�ꂪ�����̏ꍇ�A�����͂����Ă��P��x�[�X�ł͂Ȃ������x�[�X�ł��B�Ȃ̂ŁA�P��P�ʂ̃g�[�N�������g�p����A���Ȃ��̈ȑO�ɁA�u�P�ꐔ�v���̂ɂ��܂�Ӗ�������܂���B

��������ł��u�P�ꐔ�v��������ƋC�ɂ��Ă����̂́A�ߋ��ɁA�@ �̒P�ꐔ�ɑ��Ēʏ�̕����P����K�p���ꂽ�P�[�X������������ł��B����ɂ́A�������ɋ����R�c���܂����B�����P���͒P��P�����Ⴂ���Ƃ������̂ŁA���Ƃ��p�P��ł��uWAF�v�Ƃ��� 1 �P��� 1 �����̂��l�i�Ŗ��Ƃ͂ł��܂���B�p�P������̂܂g���Ƃ��Ă��A�ɂ́uWAF�v�� 3 ��������͂��܂����A�����������̑O�ɁuWAF�v�Ƃ͂ǂ������Ӗ��Ȃ̂��A�p��Ƃ��Ďg���Ă����̂��A�Ƃ����Ɩ|���Ƃ����Ă��܂��B

�|�����̌݊��� �\ 2015 �� 2017 SR1 �ł̉�͌��ʂ̍���

�����u�P��P�ʂ̃g�[�N�����v�̐ݒ�ɂ����܂ł�������Ă��܂����̂́A��L�́u�P�ꐔ�v���C�ɂȂ��Ă������ƂƂ͕ʂɁA2015 ���� 2017 SR1 �ɂȂ��Ă����܂���v�̃}�b�`���������Ԃ�オ���Ă���悤�ȋC�����Ă�������ł��B�u�}�b�`�����オ��v�Ƃ������Ƃ́A�܂�u�|����������v�Ƃ������Ƃł���A���ɁA�����܂���v�ɔ�₷��Ɨʂ͂���Ȃ�ɑ傫���Ȃ邱�Ƃ������̂ŁA�|��҂Ƃ��Ă͂�����ƍ������Ȃ��Ǝv���Ă��܂����B����ȕ����|��Җڐ��ōl���Ă������Ƃ��A����̍����̌����ł��B���݂܂���B

2015 �� 2017 SR1 �ł̉�͌��ʂ̍��قɂ��ẮA�ŏ��ɋ������u���O�́u�|�����̌݊��� SDL Trados Studio 2019 / 2017 / 2015�v�ɏڂ�����������Ă��܂��B��͌��ʂ̍��ق͉�������Ă���悤�ł����A���̍��ق̉����Ɂu�P��P�ʂ̃g�[�N�����v�̐ݒ肪�W���邱�Ƃ��Ȃ��悤�ł��B

�u�P��P�ʂ̃g�[�N�����v���g�p����Ɖ�͌��ʂ͊m���ɕς��܂����A����́A�ŏ��ɐ��������Ƃ���A�P��P�ʂʼn�͂���悤�ɂȂ�̂Ō��ʂ��ς��Ƃ������Ƃł��B�J��Ԃ��ł����A���������{��̏ꍇ�͕����x�[�X�̗����ł��B�Ȃ̂ŁA�u�P��P�ʂ̃g�[�N�����v�͎g�p�����A���̂܂ܕ����x�[�X�ʼn�͂���̂��K�ł��B�u�ǂ����ʼn�͂���}�b�`����������̂��H�v�Ƃ������|��Җڐ��̑����ōl���Ă͂����܂���ł����B(���݂܂���A���Ȃ��܂��B)

�Ƃ����킯�ō���͈ȏ�ł��B�u�P��P�ʂ̃g�[�N�����v�̓f�t�H���g�Ŏg�p���Ȃ��ݒ�ł��B�P�ꐔ�𐔂���ȊO�ɂ͓��ɈӖ��̂Ȃ��ݒ�Ȃ̂ŁA�f���ɂ��̂܂ܕ����Ă����Ă悩�����̂ł��B�}�b�`�����グ���艺������ł���s���̂����ݒ�Ȃ�āA����킯�Ȃ��ł���ˁB���낢��ƍ��������Ă��܂��A���炵�܂����B

| �@�@ |

�^�O�F�P��P�ʂ̃g�[�N���� upLIFT �e�N�m���W�[ �������A�W�A����̏ꍇ�ɒP��P�ʂ̃g�[�N�������g�p���� 2017 SR1 �P�ꐔ ������ �J�E���g

Tweet